오늘은 제가 MonoDepth를 공부하면서 거의 처음 접하게 된 Godard의 Unsupervised Monocular Depth Estimation 논문에 대한 간단한 설명을 하려고 합니다. 해당하는 설명은 제가 공부를 하면서 이해한 것으로 잘못된 부분이 있을 수 있습니다.

Mono depth estimation과 관련된 기본 배경 지식이 없으시다면 이해하기 힘드니 Mono Depth Estimation에 대한 간단한 설명! skk095.tistory.com/4 을 읽고 보시기를 추천드립니다!

먼저 Depth Estimation은 Left image와 Right image의 시차인 disparity를 구해 Depth를 구하게 됩니다.

Depth = (focal length * base line) / disparity

Godard의 논문에서는 Unsupervised 방식을 사용해 Monocular Depth를 추정하였습니다.

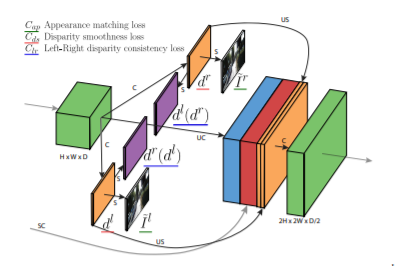

해당 논문의 Network 그림은 아래와 같습니다.

그림1과 같이 Left Image가 Input으로 들어가 CNN network를 통과 한 뒤 left disparity와 right disparity를 얻습니다.

그 후 나온 left disparity와 right disparity를 이용해 image reconsturction, left-right consistency등의 loss를 사용해서 학습을 진행합니다.

해당 논문에서 사용한 loss는 left-right disparity consistency loss와 Appearance Matching Loss, Disparity Smoothness Loss 가 있습니다.

먼저 Appearance Matching Loss 같은 경우 Image reconstruction loss라고 생각을 하면 될 것 같습니다.

모델을 통해서 나온 left disparity와 right disparity를 이용해서 Image reconstruction을 하는 것입니다.

즉, Left image에 right disparity를 적용해 right image를 얻고, Right image에 left disparity를 적용해 left image를 얻은 후 각각 위 과정을 통해 얻은 이미지와 실제 left, right 이미지와의 SSIM 비교를 통해서 유사정도를 파악해 Loss를 측정한 것입니다.

그 다음으로는 Disparity Smoothness Loss 입니다.

위의 Loss는 Disparity 경계 영역에서 끊어짐등이 발생하지 않도록 gradient x, gradient y등을 측정하는 loss 입니다.

마지막으로는 Left-Right disparity consistency Loss입니다.

해당 Loss는 모델을 통해 나온 left disparity에 right disparity를 이용해 새로운 right disparity를 얻고, 마찬가지로 right disparity에 left disparity를 이용해 새로운 left disparity를 얻어 원래의 right disparity, left disparity와 비교를 하는 loss 입니다. 제가 생각했을 때 image reconstruction 즉 첫번째 loss와 비슷하다고 생각하면 될 것 같습니다.

Godard 논문에는 네트워크에 대한 자세한 설명이 나와있습니다.

다음과 같은 architecture로 이루어진 모델이라고 합니다.

해당하는 architecture와 위에서 설명한 loss를 통해서 Unsupervised 방식으로 Monodepth를 추정하였습니다.

Eigen Split으로 측정을 한 후 시각적으로 보여준 결과 입니다.

다음은 성능평가를 한 표입니다. Godard는 cityscape과 KITTI dataset으로 훈련을 시키고, Post processing을 한 결과 성능이 잘 나온 것으 확인 할 수 있습니다.

Godard의 해당하는 논문에 대한 코드는 github에 많이 나와있습니다. 저는 해당 코드들을 분석하고 train을 시켜보았기에 혹시 모르는 사항이나 궁금한 점이 있을 경우 댓글을 달아주시면 제가 아는 선에서 답변드리도록 하겠습니다!

이상 Godard의 유명한 monodepth paper review를 마치겠습니다~